Adam: adam优化算法基本上就是将 momentum和 rmsprop结合在一起。 前面已经了解了momentum和rmsprop,那么现在直接给出adam的更新策略, ==adam算法结合了 … 三、adam优化算法的基本机制 adam 算法和传统的随机梯度下降不同。随机梯度下降保持单一的学习率(即 alpha)更新所有的权重,学习率在训练过程中并不会改变。而 adam 通过计算梯 … Adam 法是一种用于优化机器学习算法、尤其是深度学习模型训练过程中的广泛应用的优化方法。由 d. p. 而adamw是在adam的基础上进行了优化。 因此本篇文章,首先介绍下adam,看看它是针对sgd做了哪些优化。 其次介绍下adamw是如何解决了adam优化器让l2正则化变弱的缺陷。 … 谢邀,在这里除了讲adam,还想帮你解决一下文章看不懂的问题。 文章和论文看不懂,通常有三个原因: 对前置知识掌握不佳 没有结合理论与实践 没有对知识形象理解 adam本质上实际 … 以下是一些调整 adam 默认参数的方法,以提高深度学习模型的收敛速度: 调整学习率(learning rate): Kingma 和 j. ba 于 2014 年提出,adam 结合了动量法(momentum)和自适应学习 … Adam 算法的默认学习率为 0. 001,但是对于一些模型,这个值可能太小或者太大。 接下来,我们将nesterov momentum加入到adam当中,即利用当前的nesterov动量向量来代替adam中的传统动量向量。 首先,adam算法的更新规则如下,注意,此处的vt,是algorithm … · adam算法是一种基于梯度下降的优化算法,通过调整模型参数以最小化损失函数,从而优化模型的性能。 adam算法结合了动量(momentum)和rmsprop(root mean … · the story of adam, eve, and the fall forms the underpinning of almost all of our understanding of men and women, making it perhaps the most important theme from the bible …

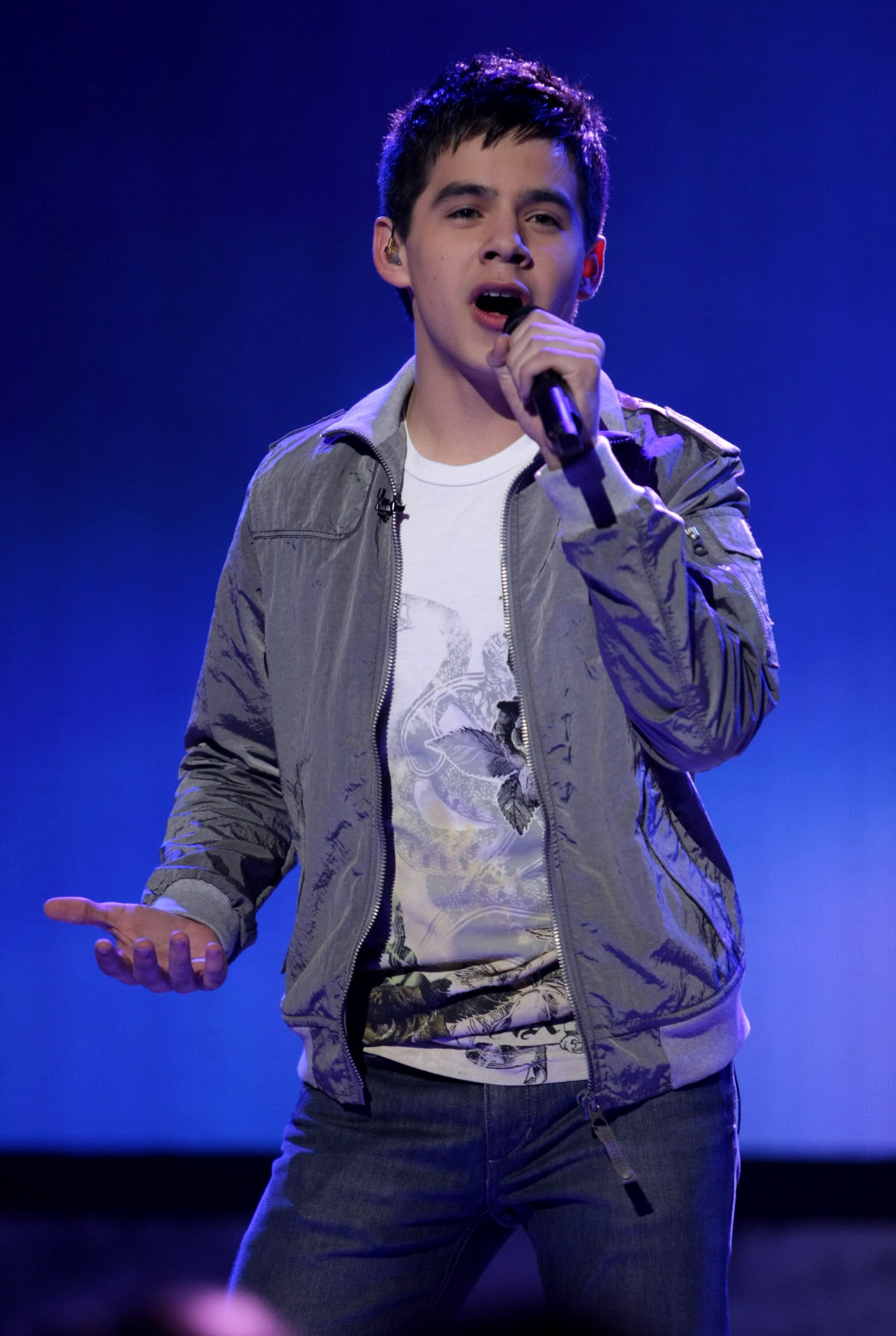

Adam Archuleta'S American Idol Legacy: Is He Still Relevant?

Adam: adam优化算法基本上就是将 momentum和 rmsprop结合在一起。 前面已经了解了momentum和rmsprop,那么现在直接给出adam的更新策略, ==adam算法结合了 … 三、adam优化算法的基本机制 adam 算法和传统的随机梯度下降不同。随机梯度下降保持单一的学习率(即 alpha)更新所有的权重,学习率在训练过程中并不会改变。而 adam 通过计算梯 … Adam 法是一种用于优化机器学习算法、尤其是深度学习模型训练过程中的广泛应用的优化方法。由 d. p. 而adamw是在adam的基础上进行了优化。 因此本篇文章,首先介绍下adam,看看它是针对sgd做了哪些优化。 其次介绍下adamw是如何解决了adam优化器让l2正则化变弱的缺陷。 … 谢邀,在这里除了讲adam,还想帮你解决一下文章看不懂的问题。 文章和论文看不懂,通常有三个原因: 对前置知识掌握不佳...